Una de las mayores desgracias que sufren los matemáticos, físicos, ingenieros y otros científicos que se ocupan de estudiar la naturaleza desde un punto de vista cuantitativo, es la de no saber resolver (en algunos casos) las ecuaciones diferenciales que esa misma naturaleza, con un poco de mala leche, les plantea. Probablemente esta afirmación no es la mejor publicidad para la ciencia y quienes la practican (… ¡que no saben resolver las ecuaciones!…, pensarán algunos imaginándose un avión en caída libre) aunque, quizá, la dificultad de encontrar dichas soluciones en términos de funciones elementales les proporcione cierto cuartelillo. De hecho, ese cuartelillo no tarda en llegar cuando se presentan ciertos antecedentes al gran público. La reacción de la hermana filóloga de un amigo que se dedica a la física de cuerdas viene bastante al caso: ¡pero cómo van a encontrar la solución!, ¿acaso has visto sus hojas? -le dijo a su madre, mientras discutíamos todos juntos el asunto, refiriéndose a las notas de su hermano. La solución analítica de las ecuaciones diferenciales es por tanto como un ciervo blanco. Pero, ¿quién la necesita cuando se puede encontrar una buena aproximación?

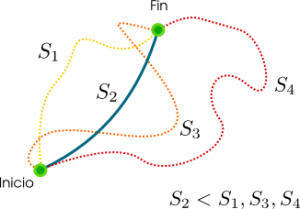

El Análisis es la rama de las matemáticas que se encarga, entre otras cosas, de demostrar que la solución de las ecuaciones diferenciales existe (lo que, aunque los científicos aplicados no lo crean, resulta un gran alivio), mientras que el Análisis Numérico, entre otras cosas, se ocupa de encontrar aproximaciones de esas esquivas soluciones, que llamaremos integradores, y de estudiar sus propiedades. Las ecuaciones de la física clásica tienen carácter diferencial y se obtienen a partir de la acción de un sistema dado (integral de la función lagrangiana) a partir de principios variacionales (para entradas anteriores sobre este tema ver aquí, aquí o aquí). Se puede probar la existencia de las soluciones a dichas ecuaciones, aunque en muchos casos, sobre todo en los más complejos (que suelen coincidir con los de mayor interés práctico) no sabemos encontrarlas. ¿Debemos encogernos en un rincón y ponernos a llorar? ¡Ni mucho menos! Como se menciona antes, el Análisis Numérico nos echa una mano con sus integradores.

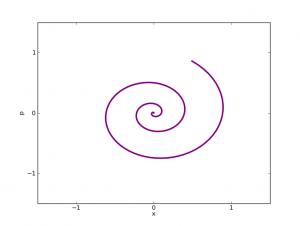

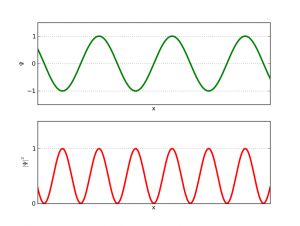

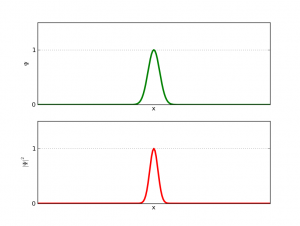

Por otro lado, desde la mitad del siglo pasado se han introducido métodos topológicos y geométricos en el estudio de las ecuaciones diferenciales, en especial de aquellas que provienen de la física y que están relacionadas con sistemas mecánicos (desde los más simples, como puede ser un péndulo o una bolita deslizándose plano abajo, hasta los más complejos, como puede ser el Sistema Solar). Este nuevo campo de investigación que reformula la Mecánica Clásica en lenguaje geométrico se llama actualmente Mecánica Geométrica, y nos enseña interesantes propiedades de las soluciones a las ecuaciones mecánicas. Habitualmente, estas propiedades están relacionadas con la preservación de alguna cantidad geométrica. Ejemplos son la forma simpléctica, cuyo nombre asusta pero que está conectada de una forma más pedestre con el volumen del sistema bajo estudio, o las aplicaciones momento, inquietantes objetos en íntima relación con la simetría de las funciones lagrangiana o hamiltoniana y que nos dan información sobre los invariantes del sistema y parte de su comportamiento (por ejemplo, el hecho de que las órbitas de los planetas estén contenidas en un plano puede explicarse de forma sencilla diciendo que el momento angular de dicho planeta se conserva). El concepto de simetría tiene gran importancia en las matemáticas y física modernas, sobre todo a nivel cuántico. Su vínculo con la preservación de cantidades geométricas, cantidades que en algunos casos tienen una interpretación física reconocible, se encapsula en uno de los hitos más importantes de las matemáticas del siglo XX: el teorema de Noether.

Todo lo anterior está perfectamente formalizado cuando pensamos en las soluciones exactas a las ecuaciones diferenciales (que sabemos que existen). A nivel práctico… ¿qué pasa cuando no sabemos encontrarlas? ¿Nos echamos a llorar de nuevo? ¿Tienen nuestros útiles integradores las mismas propiedades? ¿Preservan a nivel numérico las mismas cantidades que sus contrapartes exactas preservan a nivel continuo? El área de las matemáticas que se encarga de responder a estas preguntas a nivel geométrico es la Mecánica Discreta, área relativamente moderna y en plena ebullición. La respuesta suele ser positiva, bajo ciertas condiciones, lo que nos ofrece una bonita simetría especular entre el mundo de las soluciones exactas y el mundo de los integradores. ¿Hay alguna forma variacional de obtener dichos integradores, tal y como ocurre con las ecuaciones continuas de la física? De nuevo la respuesta es sí, lo que da lugar a uno de los objetos más interesantes y más prácticos dentro de la Mecánica Discreta: los integradores variacionales. La última pregunta suele ser la más peliaguda: ¿son realmente mejores, en algún sentido, los integradores con propiedades geométricos que aquéllos que no las tienen? Pensándolo fríamente, a la hora de simular un sistema mediante un integrador, lo que uno pretende es que dicho integrador sea eficiente, robusto, preciso (es decir, que se aproxime a la solución exacta lo máximo posible) y que sea fácil de traducir en algoritmos comprensibles por un ordenador. Bajo estas consideraciones se puede decir que los integradores geométricos, en concreto los variacionales, no son mejores ni peores que los demás. Lo que sí se comprueba es que algunos de ellos, en concreto los que preservan la forma simpléctica, presentan gran robustez cuando se hacen simulaciones a tiempos largos (son simplécticos, por ejemplo, los integradores empleados en las simulaciones del Sistema Solar).

Lo que sí se puede concluir en cualquier caso, es que tanto el Análisis Numérico como cualquiera de sus estribaciones geométricas, ya sea en forma de Integración Geométrica o Mecánica Discreta, no son áreas menores de las matemáticas o una forma humilde de capitular ante la incapacidad de encontrar soluciones analíticas a ciertas ecuaciones. Todo lo contrario, son ramas poderosas, intrigantes y de gran utilidad práctica, que nos proporcionan lo que la mayoría de las veces resulta más inteligente: una forma de encontrar una solución alternativa y aproximada a un problema demasiado difícil. O en otras palabras: una forma de avanzar en lugar de quedarse paralizado.

–Nota: Esta entrada la ha escrito Fernando Jiménez.